你是否厭倦了手動執行重複性任務?超過 80% 的工程師都面臨著這個問題。Airflow 是一個強大的開源工作流程自動化平台,可以幫助你擺脫繁瑣的手動操作,讓你專注於更重要的任務。

Airflow 用於以程式化的方式設計、安排和監控工作流程。由於 Airflow 是用 Python 開發的,只要熟悉 Python 語言,就能輕鬆上手。此外,作為一個專門處理工作流程的工具,Airflow 能夠與多種類型的工具、軟體和資料庫無縫整合。即使 Airflow 本身不直接支援串接某些特定工具,使用者也可以透過自定義插件來擴展其功能,展現出極高的靈活性。具體可以實現哪些事情,大家就參考官網吧!

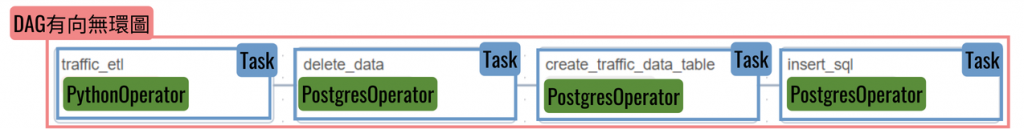

有向無環圖(DAG):

DAG 是一種具有方向但不會形成循環的圖結構,代表一組有依賴關係的任務,通常用來描述工作流程。DAG 描述了任務的執行順序和依賴關係,但不包含具體的執行邏輯。由於 Airflow 在執行工作流程時,這些流程是線性的、有限的,最終會結束,因此用無環圖來表示是非常適合的。DAG 決定了每個任務節點之間的順序和關係,從而設計出工作流程的運作方式。

任務(Task):

Task 是 DAG 中的基本執行單元,每個 Task 都代表一個獨立的操作,可以是運行一個 Python 腳本、執行一個 SQL 查詢、調用 API 等。

操作器(Operator):

Operator 是 Task 的模板,定義了 Task 的行為,是更細緻的執行單元,它們被包含在 Task 之中。Airflow 提供了多種內建 Operator ,如 PythonOperator、BashOperator、MySqlOperator 等,使用者也可以自定義 Operator 。每個 Task 可能由多個 Operator 組成,而每個 Operator 負責執行特定的任務。這樣的結構使得任務可以靈活地拆解和執行。以下是幾個常見的 Operator 範例:

調度器(Scheduler):

Scheduler 負責根據 DAG 定義的時間間隔調度任務。它會持續監控 DAG,發現需要執行的任務並將其放入執行隊列。

執行器(Executor):

Executor 負責執行 Scheduler 分配的任務。Airflow 支援多種執行器,包括 SequentialExecutor(順序執行)、LocalExecutor(並行執行)、CeleryExecutor(分佈式執行)等。

鉤子(Hook):

Hook 是對外部系統的介面,如資料庫、API 等。Operator 通常通過 Hook 與外部系統交互。

連接(Connection):

Connection 是對外部資源的配置,包含訪問外部資源所需的認證資訊和其他相關配置。

DAG 定義:

DAG 通常用 Python 代碼定義,包含 DAG 的 ID、調度間隔、任務依賴關係等資訊。以下是一個簡單的範例:

from airflow import DAG

from airflow.operators.bash import BashOperator

from datetime import datetime

with DAG(

'example_dag',

default_args={

'start_date': datetime(2023, 1, 1),

'retries': 1,

},

schedule_interval='@daily',

) as dag:

task1 = BashOperator(

task_id='print_date',

bash_command='date',

)

task2 = BashOperator(

task_id='echo_hello',

bash_command='echo Hello, World!',

)

task1 >> task2

任務調度:

配置好 DAG 後,Airflow 調度器會自動根據 DAG 定義的調度間隔執行任務。使用者可以在 Web 介面中監控任務的執行情況,並進行手動觸發或暫停任務。

錯誤處理:

Airflow 提供了多種錯誤處理機制,包括任務重試、警報通知、任務依賴關係定義等。使用者可以通過配置任務的 retries、retry_delay、email_on_failure 等參數來實現錯誤處理。

任務依賴管理:

在定義 DAG 時,任務之間的依賴關係是通過 >> 或 << 操作符指定的。Airflow 還支援基於任務執行狀態的動態依賴管理,例如 TriggerRule。